软银发布 AI 数据中心软件平台 Infrinia AI Cloud OS,利用自动化统一管理 GPU 算力堆栈

发布时间:

1月21日消息,软银公司宣布旗下Infrinia团队正式开发完成面向未来AI数据中心的软件平台“Infrinia AI Cloud OS”。

软银指出,随着生成式AI、自动化机器人、仿真计算、药物研发以及新材料开发等领域对GPU加速算力的需求持续快速增长,当下AI计算的使用场景和需求形态正变得愈发多样和复杂。为应对这些挑战,软银旗下Infrinia团队开发了Infrinia AI Cloud OS,目标是在充分释放GPU性能的同时,实现先进GPU云服务的快速部署与高效运维。

具体来说,Infrinia AI Cloud OS可帮助AI数据中心运营方在多租户环境中以较低成本构建AI服务体系,相应软件平台将率先部署在公司自有的GPU云服务中,未来计划将其推广至海外数据中心和云环境,推动在全球范围内的落地应用。

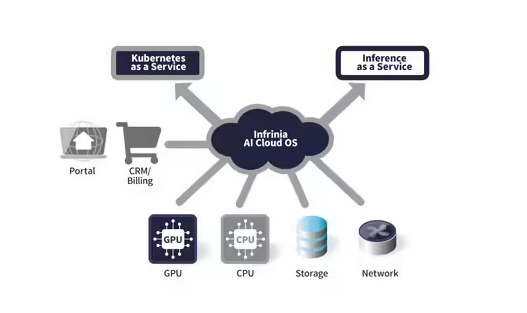

在功能层面,Infrinia AI Cloud OS提供完整的Kubernetes即服务能力,可在包括英伟达GB200 NVL72在内的GPU平台上,对从BIOS、RAID、操作系统、GPU驱动、网络,到Kubernetes控制器与存储在内的整个技术栈进行自动化管理,大幅降低基础设施和平台层的运维复杂度。

同时,该系统支持基于软件定义的动态物理互联与内存重构能力,能够在用户创建、更新或删除集群时,按需实时调整连接方式和跨节点内存配置,并依据GPU拓扑结构与NVLink域进行自动节点分配,以降低延迟并最大化GPU间带宽,适用于大规模分布式AI任务。

官方同时强调,Infrinia AI Cloud OS还针对多租户场景提供了高安全性与高可运维性设计,通过加密的集群通信与隔离机制实现租户级安全防护,并对系统监控、故障切换等运维工作进行自动化。同时平台还提供了API接口,便于与AI数据中心门户、客户管理系统以及计费系统对接。